UX 720°

Die BUSSE Methode für erfolgreiche Usability

Der Begriff Benutzeroberfläche wird von vielen verwendet, um sich nur auf die grafische Benutzeroberfläche von Software zu beziehen. Anstelle dieser restriktiven Definition sehen wir bei BUSSE die Benutzeroberfläche in ihrem ursprünglichen Sinne – d. H. viel mehr als nur Software und Touchscreens.

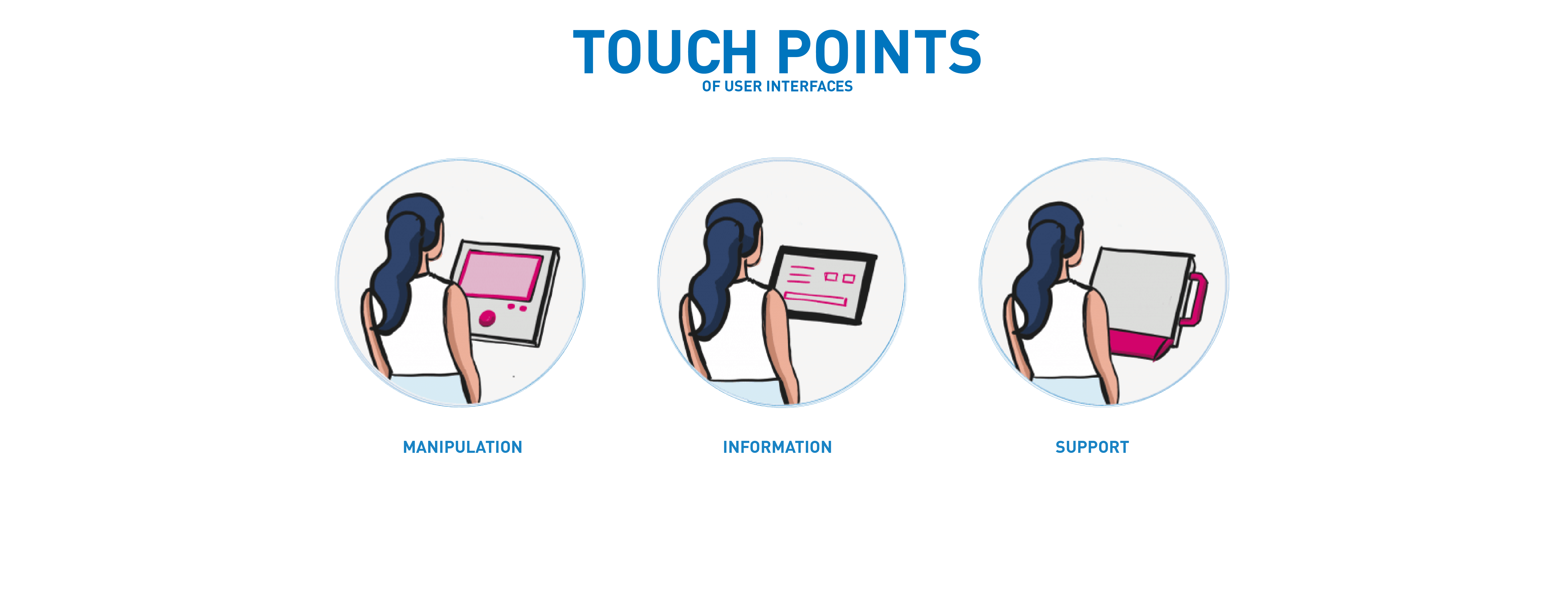

Durch eine ganzheitliche Betrachtung aller relevanten Berührungspunkte werden alle Elemente nach ihren Funktionen kategorisiert: Manipulation, Anzeige und Unterstützung. Nur so kann sichergestellt werden, dass die bestmöglichen Elemente der Benutzeroberfläche ausgewählt werden, um alle Anforderungen der Produktion, der Geräteumgebung und der Benutzerergonomie zu erfüllen.

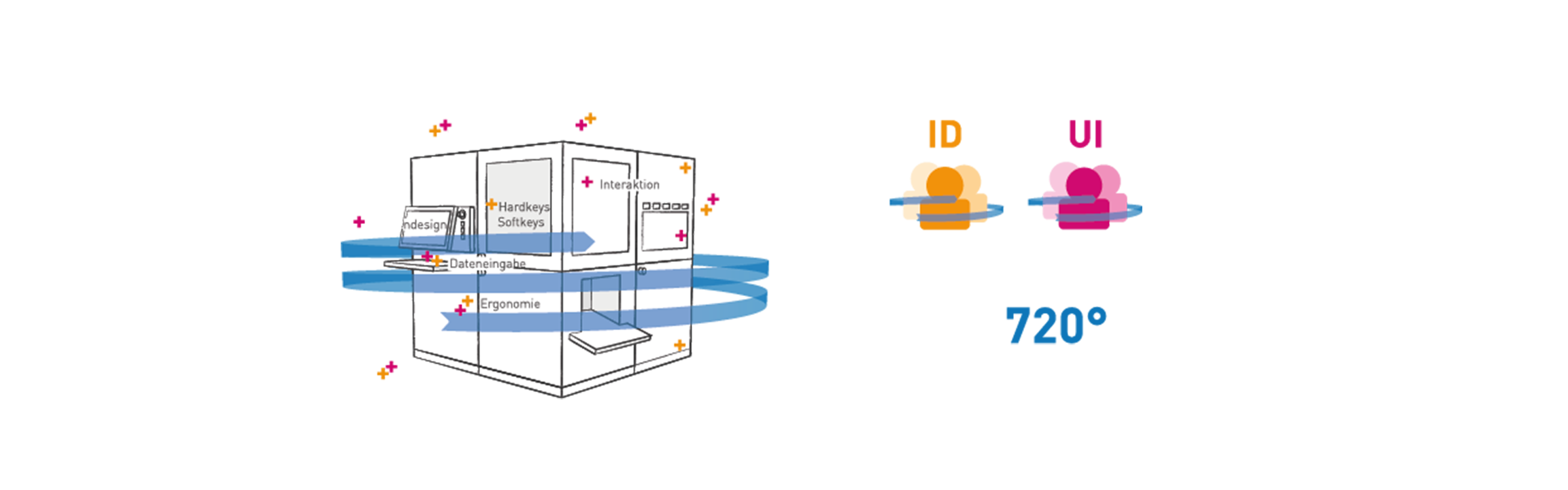

Wir betrachten die Entwicklung Ihrer Produkte sowohl aus Hardware als auch aus Software-Sicht. Deswegen haben wir den Human Centered Design Process weiter gedacht und gehen in der Entwicklung wortwörtlich 2x um ein Produkt: Mit dem anwenderorientierten Blick eines UI / UX Designers und aus der dreidimensional-funktionalen Sicht des Industriedesigners und Ingenieurs. So gehen ein optimales Bedien- und Ergonomiekonzept Hand in Hand und es entstehen nicht nur durchdachte und bedienbare Produkte, sondern Produkte die ein positives, markenprägendes Erlebnis durch professionelle Gestaltung hinterlassen. Somit ist die Usability und die optimale Bedienbarkeit und Prozesssicherheit ein zentraler Bestandteil.

Unser Leistungsspektrum

- Ergonomiestudien

- Erfassen von Use Cases und Nutzergruppen und deren Anforderungen

- Recherche und Identifikation von Interaktionselemente

- Platzierung von physischen Anzeige- und Eingabeelementen

- Definition von Bedienabläufen, Menüstruktur und Screeninhalt

- Erstellen von Modellen (physisch und digital)

- Nutzervalidierungen

AR/VR als einfache Visualisierungsmethode

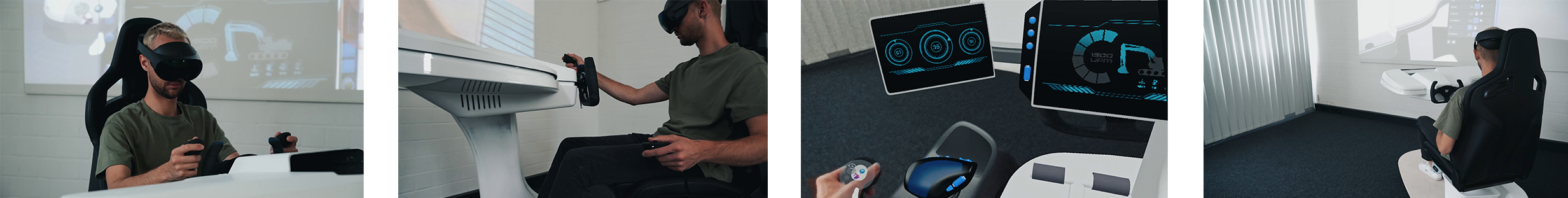

Über eine Kombination aus Modellbau, Interfacedesign und 3D Datenkönnen wir Bedienkonzepte über Hybrid Augmented Reality erlebbar, bewertbar und veränderbar machen.

Häufig steht man in der Produktentwicklung an dem Punkt, dass Ergonomie und Usability an einem Produkt, inkl. Designaspekte und Machbarkeit bewertet werden müssen. Ein digitales Bedienkonzept kann ganz einfach über Klickdummies in Usability Tests geprüft werden. Ein physisches Produkt kann über Design- oder Ergonomie Modelle bewertet werden. Was aber, wenn beides in Kombination und anhand verschiedener Konzepte bewertet, ausprobiert und verbessert werden muss? Über Modellbau könnte man unterschiedlichste Setups aufbauen, mit jeder Variante steigen aber auch die Kosten dafür in die Höhe.

Um genau diese Problematik in den Griff zu bekommen, haben wir unsere UX720° Methode weiterentwickelt:

Mittels Aufbaus von CAD Daten und physischen Elementen, z.B. bestehend aus Sitz und Lenkeinheit in Virtual Reality, können zusätzlich unterschiedlichste Konzepte für Bedienschnittstellen, wie Joysticks, Displays in unterschiedlichen Größen und Ausrichtungen, Hardkeys oder Steuerelemente aufgebaut und mit digitalen Interfacedesign Elementen versehen werden.

In einem gemeinsamen Workshop können dann unterschiedliche Szenarien über eine VR-Brille ausprobiert werden, da über die 3D Darstellung alle Bedienschnittstellen greifbar und verschiebbar sind.

So können neue Konzepte mit optimaler Ergonomie und Usability entstehen. Über einen Bildschirm oder den Beamer wird das erlebte des VR-Brillenträgers live für alle Teilnehmenden übertragen. Das spart Zeit und aufwändige Entwicklungsschleifen und somit auch Kosten.

Diese Vorgehensweise ist nicht nur für Fahrzeugkabinen umsetzbar, sondern kann auf jedes Produkt mit mehreren denkbaren Bedienschnittstellen übertragen werden.

Unsere Kompetenz wird nicht nur durch 400+ Auszeichnungen belegt, sondern auch durch die Begeisterung unserer Kunden.